本地部署Deepseek

DeepSeek 大火,我们也来看看如何部署本地的 DeepSeek。

🎉 DeepSeek-R1 已发布并开源,性能对标 OpenAI o1 正式版,在网页端、APP 和 API 全面上线。

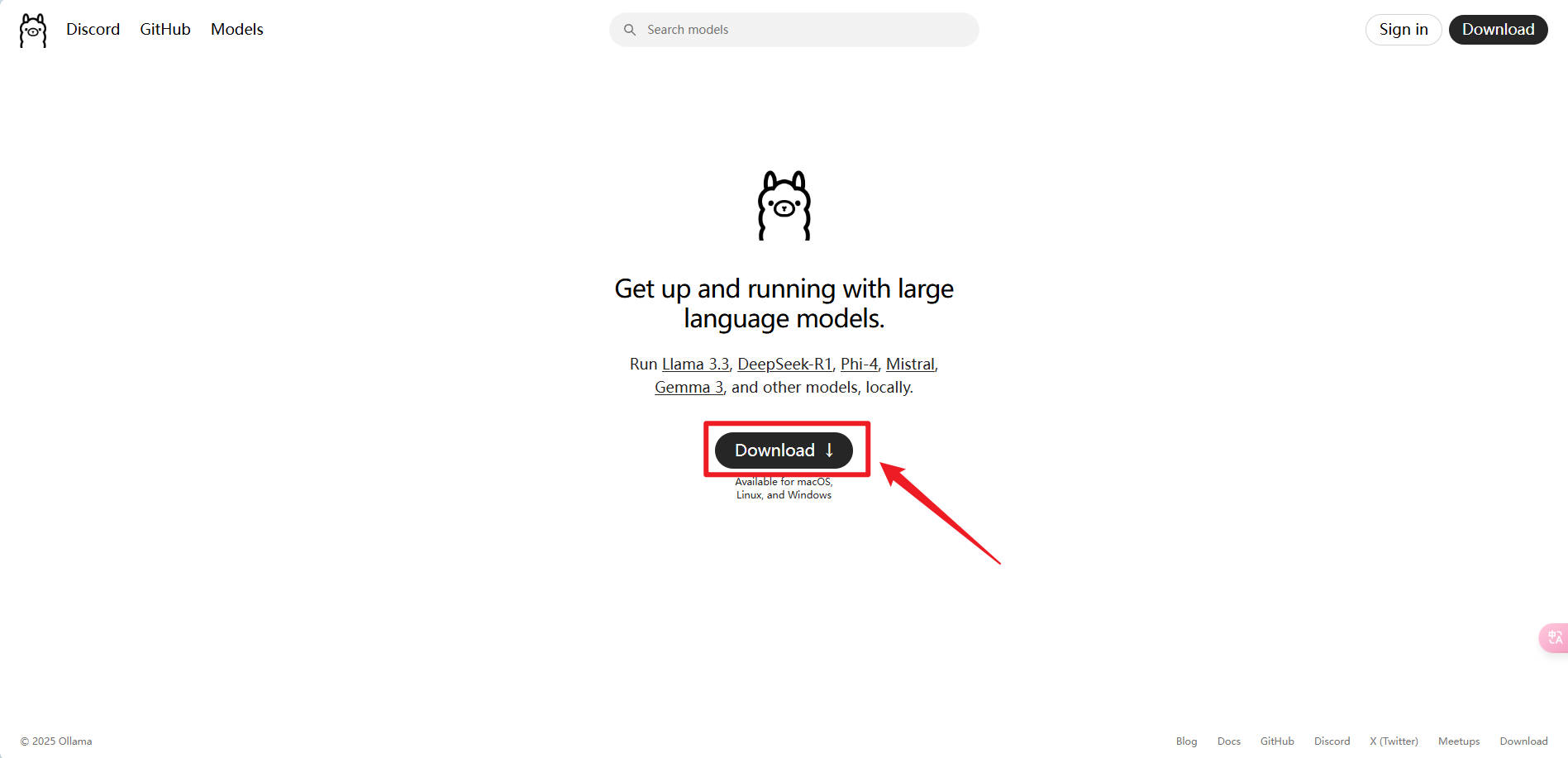

安装ollama

- 访问

Ollama官网

ollama 的图标这是一只?羊驼?

根据你的操作系统选择合适的安装包,我这里以 Windows 为例

点击 Download 按钮,选择 ollama 安装包,下载完成后解压。

-

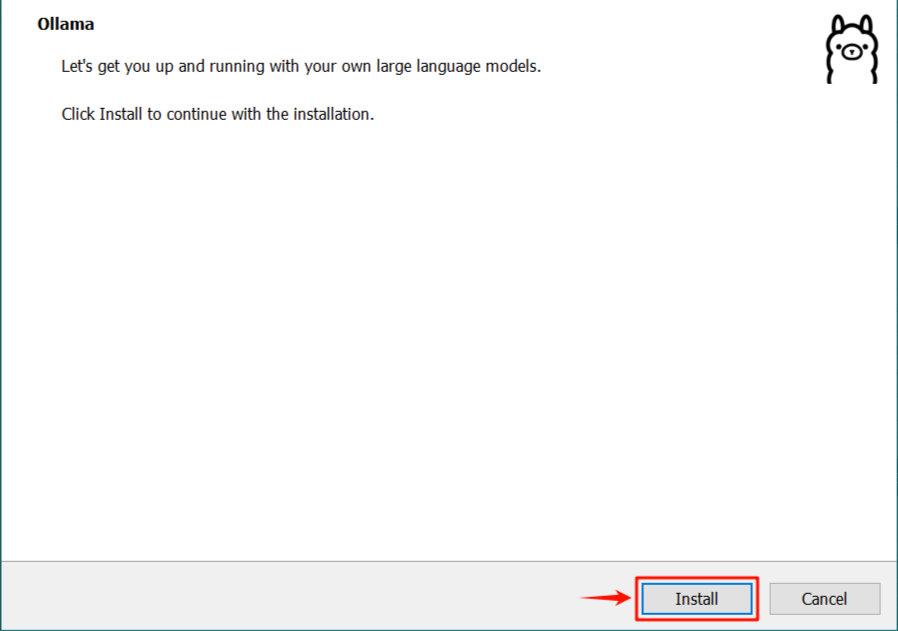

Ollama可以傻瓜式安装,直接运行并下一步即可。这种做法的弊端是默认安装在C盘的C:\Users\用户\AppData\Local\Programs目录下,占用磁盘空间。 -

也可以手动安装,可以以选择安装在任意位置,比如

D:\ollama目录下。

这里介绍一下如何手动安装。

定位到 OllamaSetup.exe 所在的目录,以管理员身份运行 CMD

命令中DIR的值为 D:\Ollama,该值就是安装的目录位置

执行上述命令后,会弹出 OllamaSetup.exe 安装窗体界面,此时我们点击 Install 按钮等待安装完成即可

验证Ollama 是否安装成功

在 powershell 命令行中输入以下命令

如果显示了如下内容,则说明安装成功 🎉

配置Ollama 安装DeepSeel 位置

此时可以去配置一下 ollama 安装 deepseek 的位置

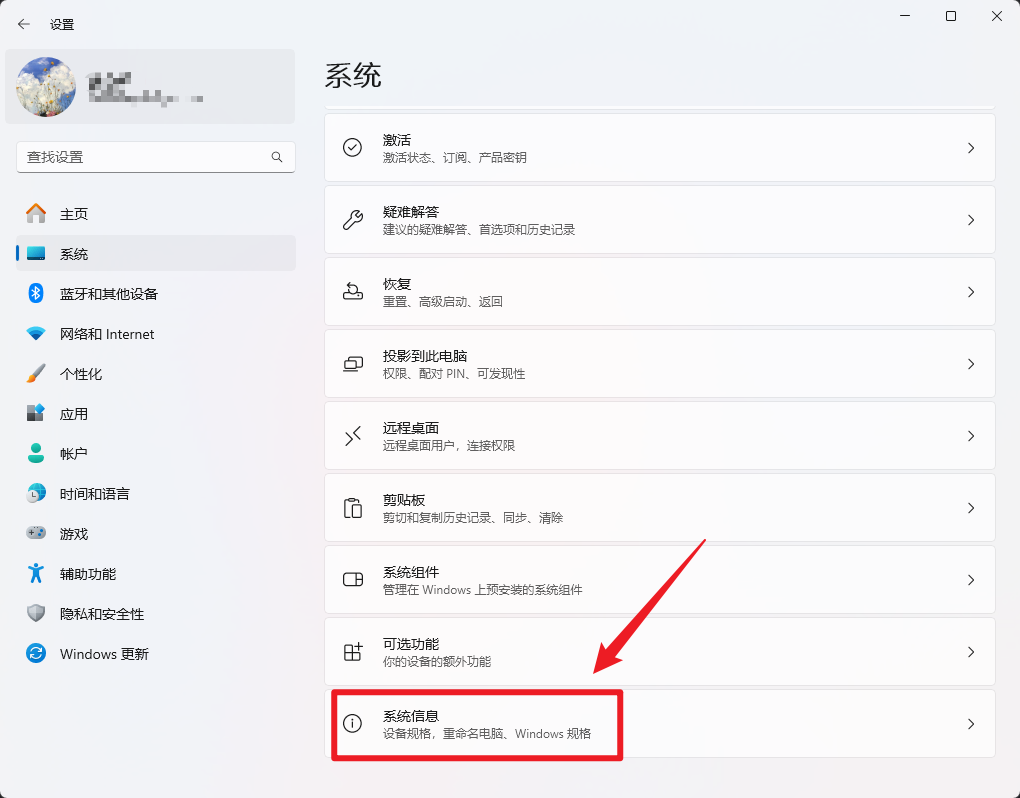

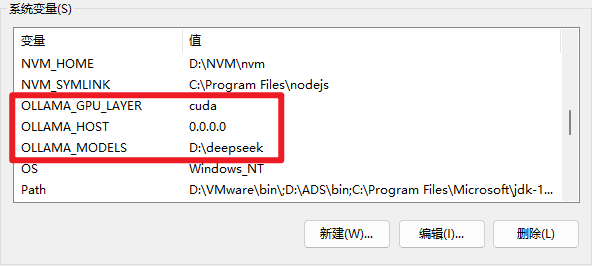

- 打开系统设置 的 系统信息

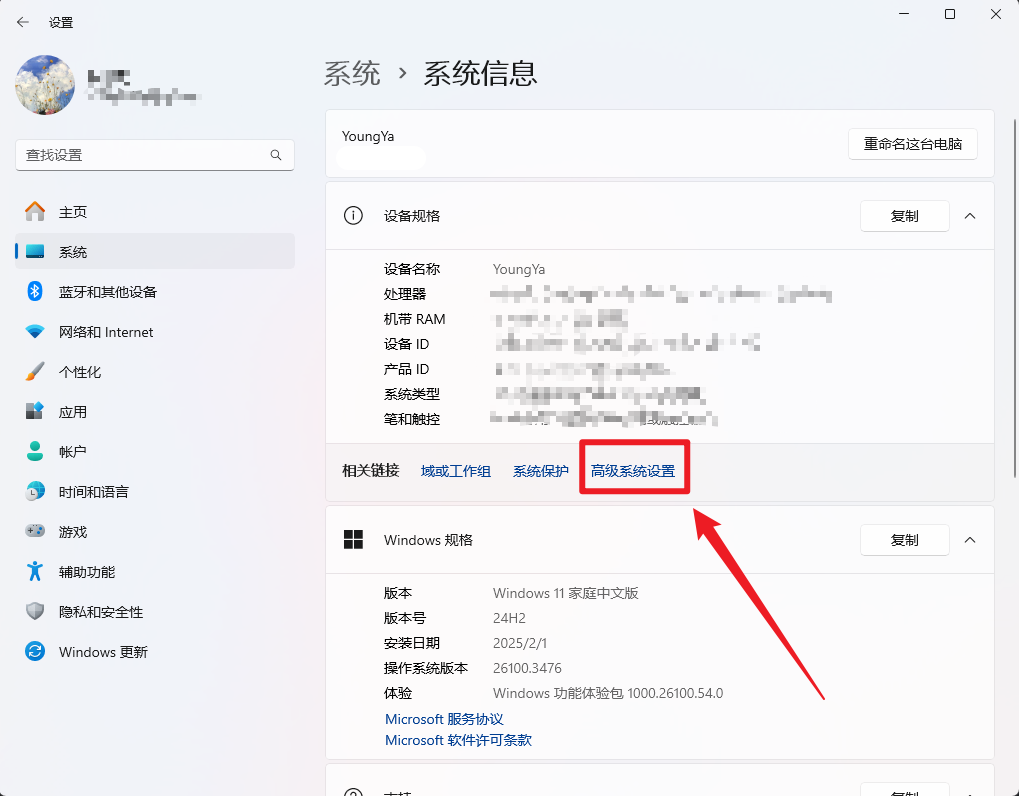

- 点击 高级系统设置

- 点击 环境变量

- 在 系统变量 中添加以下内容,然后点击确定

配置 OLLAMA_MODELS 变量,值为你想要安装模型的位置,

Ollama 服务使用环境变量 OLLAMA_HOST 来指定监听的地址,默认情况下,它只监听 localhost,即只能本地访问。如果要让局域网内其他设备访问 Ollama 服务,需要将 OLLAMA_HOST 设为 0.0.0.0

启用 cuda 显存加速,也就是使用 GPU, 前提是你的 GPU 支持 CUDA,否则不用配置

- 重启

powershell命令行即可生效

安装DeepSeek

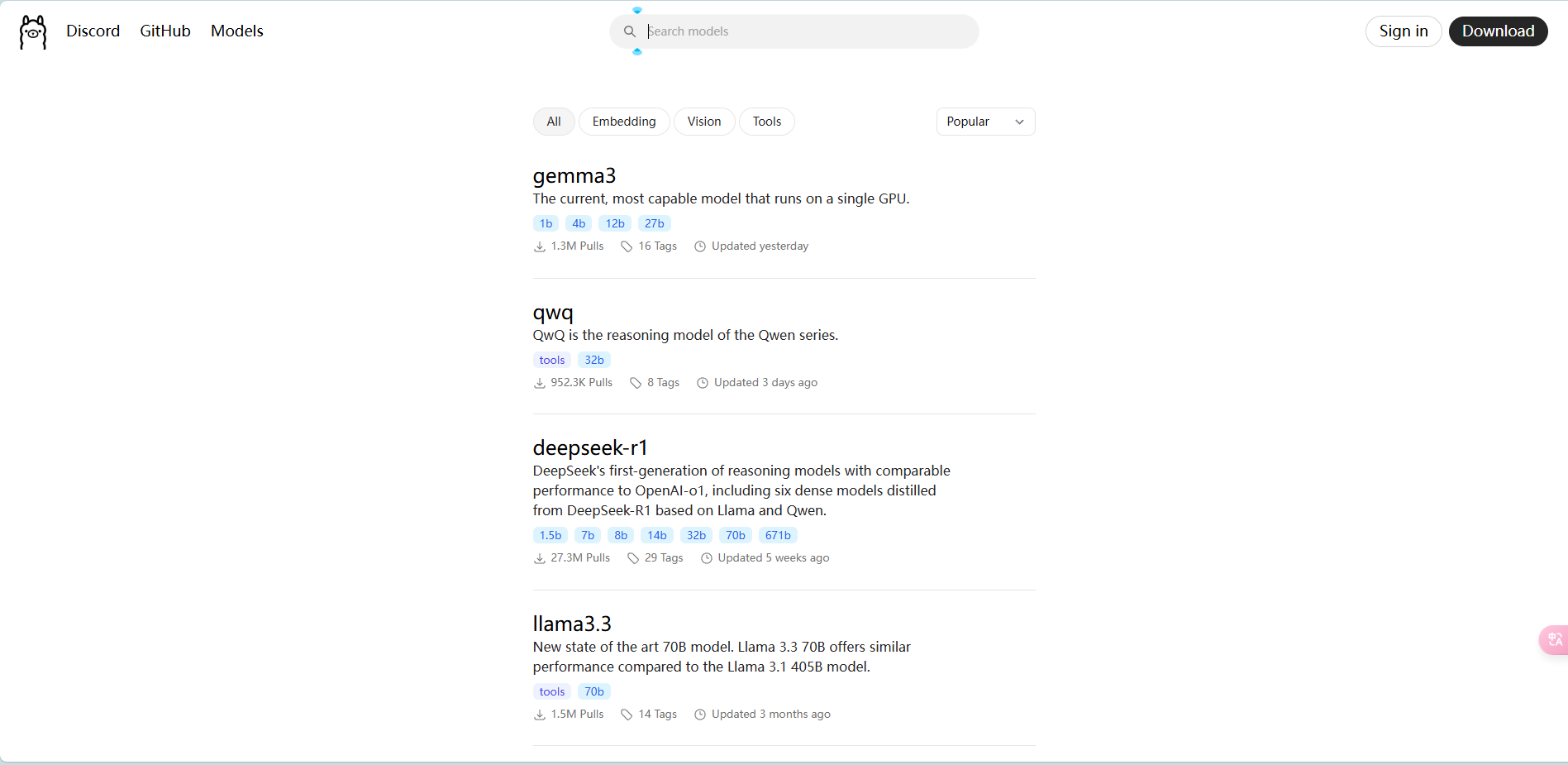

- 访问

Ollama的models官网

- 选择模型

选择一个 DeepSeek 模型,越大的模型,越耗费内存,越耗时,越精准

越小的模型,越快,精度越低,根据自己的电脑配置来选择一个合适的模型

- 安装模型

在 powershell 命令行中输入以下命令

这个过程需要一段时间,请耐心等待

等待安装完成后就可以使用了

当然除了命令行之外,ollama还提供了请求端口 http://localhost:11434/v1/

你可以使用 cherry studio 来进行连接